Um Ihnen die Funktionen unseres Online-Shops uneingeschränkt anbieten zu können setzen wir Cookies ein. Weitere Informationen

NVIDIA DGX™ H100

Hier finden Sie die Nachfolger DGX H200 und DGX B200.

Erweitern Sie Ihre Möglichkeiten mit der NVIDIA DGX™ H100. Die NVIDIA DGX™ H100 ist das neueste Modell der legendären DGX-Serie von NVIDIA und die Grundlage von NVIDIA NVIDIA DGX SuperPOD™. Die neue Technologie der NVIDIA H100 Tensor Core-GPU beschleunigt Ihre Prozesse und bietet neue Dimensionen im Bereich der KI und AI.

|

Die NVIDIA DGX™ H100 ist die vierte Generation der DGX Serie. Sie eignet sich perfekt für den Einsatz im Bereich der künstlichen Intelligenz. Die Hardware sowie die umfangreiche Softwareplattform sind dafür optimiert. Zusätzlich erhalten Sie ein umfangreichen Support und Zugriff auf Expertenberatung durch professionelle NVIDIA-Services. |

|

NVIDIA DGX™ H100 bietet im Vergleich zu der NVIDIA DGX™ A100 6-mal mehr Leistung, 2-mal schnelleres Networking und Skalierbarkeit in Hochgeschwindigkeit für NVIDIA DGX SuperPOD™. Die Architektur der nächsten Generation ist für enorm umfangreiche Workloads wie die Verarbeitung natürlicher Sprache und Deep-Learning-Empfehlungsmodelle optimiert.

|

|

Genießen Sie den kompletten Service sowie die Unterstützung durch unsere von NVIDIA zertifitzierten Techniker. Die Installation sowie die Einrichtung erfolgt vor Ort. Egal ob im Labor oder im Rechenzentrum. Sie erhalten die passende Compliance in der gewünschten Umgebung. |

Die neuen Features der Hopper Generation

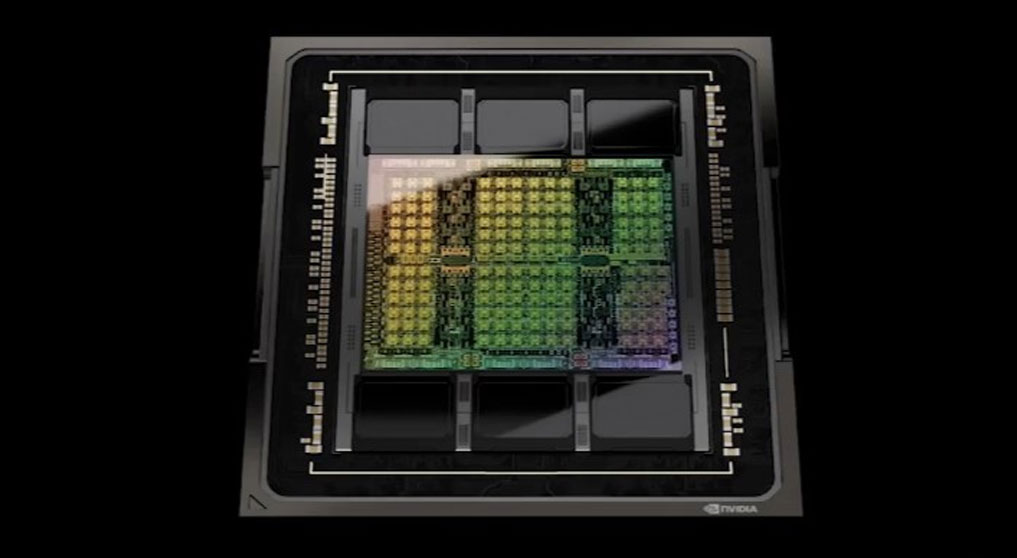

NVIDIA DGX™ mit bis zu 8x NVIDIA H100 Tensor Core GPUs (SXM5)

Mit dem NVIDIA H100 Tensor-Core-Grafikprozessor profitieren Sie von beispielloser Leistung, Skalierbarkeit und Sicherheit für jeden Workload.

■ 640GB GPU Memory (HBM3)

■ 18x NVIDIA® NVLink® (4. Generation) pro GPU

■ 900 GB/s bidirektionale Bandbreite

■ Bis zu 256x GPUs per NVIDIA® NVSwitch™ in einem NVIDIA DGX SuperPOD™-Verbund

Rechenleistung im Vergleich | NVIDIA H100 Tensor Core GPU | NVIDIA A100 Tensor Core GPU |

FP8 | 4.000 TFLOPS | 6x |

| FP16 | 2.000 TFLOPS | 3x |

| TF32 | 1.000 TFLOPS | 3x |

| FP64 | 30 TFLOPS | 3x |

NVIDIA Spectrum™-4 400GbE/ 800GbE Switch Platform

Mit dem NVIDIA Spectrum™-4 Switch können Sie die volle Bandbreite und Leistung der NVIDIA H100 Tensor Core GPUs nutzen. Der Switch besitzt 64 Ports mit jeweils 800GBit/s. Insgesamt kann somit ein Netzwerktraffic von 51.2 TBit/s (64x 800 GBit/s) erreicht werden. Der im Switch verbaute ASIC hat 100 Milliarden Transistoren und ist somit der größte ASIC in einem Switch der je verbaut wurde.

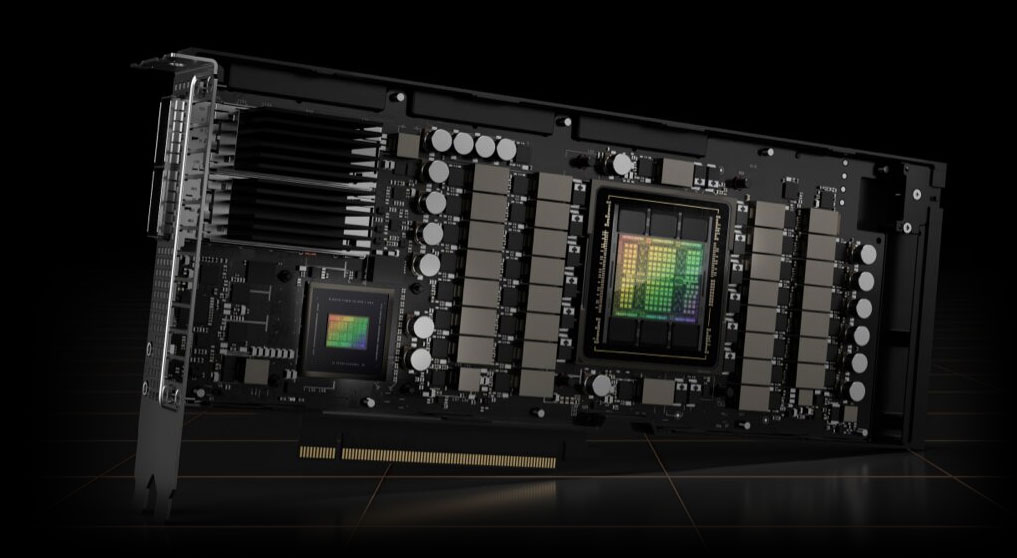

Perfekte Kombination aus GPU und Netzwerkkarte

Bei der NVIDIA H100 CNX PCIe Steckkarte wird die neue GPU und die fortschrittlichen Netzwerkfunktionen der NVIDIA-ConnectX-7 (SmartNIC) perfekt kombiniert, so dass Input/Output(IO)-intensive Prozesse dadurch deutlich besser beschleunigt werden. Die TDP der Karte beträgt 350W.

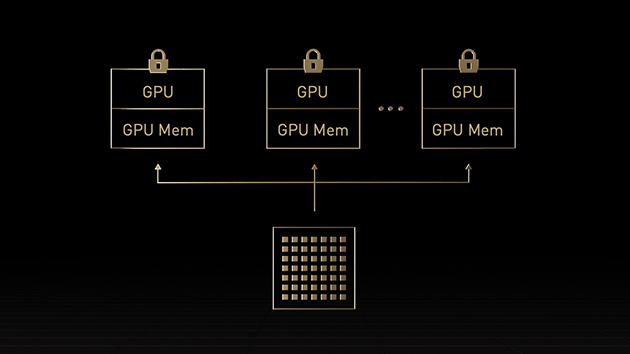

MIG der zweiten Generation

Ein Mehr-Instanzen-Grafikprozessor (MIG) kann in mehrere kleinere, vollständig isolierte Instanzen mit eigenem Speicher, Cache und Recheneinheiten aufgeteilt werden. Die Hopper-Architektur verbessert MIG noch weiter und unterstützt mandantenfähige Multi-User-Konfigurationen in virtualisierten Umgebungen für bis zu sieben Grafikprozessorinstanzen, wobei jede Instanz durch Confidential Computing sicher auf Hardware- und Hypervisorebene isoliert ist. Dedizierte Videodecoder für jede MIG-Instanz erlauben intelligente Videoanalysen (IVA) mit hohem Durchsatz auf gemeinsam genutzter Infrastruktur. Mit dem gleichzeitigen MIG-Profiling von Hopper können Administratoren die korrekt dimensionierte Grafikprozessorbeschleunigung überwachen und die Ressourcenzuweisung für Benutzer optimieren.

Forscher mit kleineren Workloads können anstelle einer vollständigen CSP-Instanz MIG verwenden, um einen Teil eines Grafikprozessors sicher zu isolieren, und sich dabei darauf verlassen, dass ihre Daten bei Lagerung, Übertragung und Verarbeitung geschützt sind.

DGX Server im Vergleich

NVIDIA DGX™ H100 (Hopper) | NVIDIA DGX™ A100 (Ampere) | |

| GPUs | 8x NVIDIA H100 Tensor Core GPU (SXM5) | 8x NVIDIA A100 Tensor Core GPU (SXM4) |

| Architecture | 4nm - customized for NVIDIA (Release 2022) | 7nm (Release 2020) |

| GPU Memory pro System | 640 GB (8x 80GB) HBM3 | 640 GB (8x 80GB) HBM2 |

| Anbindung an CPU | PCIe 5.0 x16/x32 (128 GB/s) | PCIe 4.0 x16 (64 GB/s) |

| Interconnect GPUs | NVLink Switch (900 GB/s) | NVLink Switch (600 GB/s) |

| Performance | 32 petaFLOPS | 5 petaFLOPS |

| Transistoren | 80 Milliarden | 54.2 Milliarden |

| NVIDIA CUDA Cores / GPU (FP32) | 135.168 | 55.296 |

| NVIDIA CUDA Cores / GPU (FP64) | 67.584 | 27.246 |

| NVIDIA Tensor Cores (TF32) | 4.224 | 3.456 |

| Multi Instance GPU support | ja | ja |

| CPU | 2x Intel® Xeon® Platinum 8480C Processors 112 Cores total, | 2x AMD EPYC 7742 insgesamt 128 Kerne, 2.25 GHz |

| System Memory | 2.0 TB DDR4 | 2.0 TB DDR4 |

| Network InfiniBand / Ethernet | 8x 400G NDR | 400G Ethernet | 8x 200G HDR | 200G Ethernet |

| Network Ethernet | - | 2x Dual Port 200 GbE |

| Storage OS | 2x 1.92 TB NVMe SSD | 2x 1.92 TB NVMe SSD |

| Storage Data | Total 30 TB NVMe SSD | Total 30 TB NVMe SSD |

| Software | Ubuntu Linux 22.04 Red Hat Linux | Ubuntu Linux 20.04 Red Hat Linux |

| Gewicht | 130 kg | 123 kg |

| Bauform | 8U / Tiefe 897 mm | 6U / Tiefe 897 mm |

| Temperaturbereich | 5 – 30°C | 5 – 30°C |

| Maximum Power Usage | ~10.2 kW max (6x redundant power supplies) | 6.5 kW |

| weitere Informationen | Datenblatt | Datenblatt |

Die NVIDIA Hopper™ Architektur im Detail

Der technische Blog von NVIDIA ist gefüllt mit einer Menge an Informationen, originalen Bildern, Skizzen sowie Tabellen.

Die komplette Architektur wird im Detail behandelt und genaustens beschrieben.

GTC 2023 Keynote mit NVIDIA CEO Jensen Huang

Haben Sie Fragen zu der NVIDIA DGX™ H100 oder weitere Fragen zu den NVIDIA Produkten?

Wir helfen Ihnen gerne weiter. Rufen Sie uns an, schicken Sie eine Mail oder nutzen Sie uner Anfrageformular: NVIDIA DGX Angebo

Kontakt: Tel: +49 40 300672 - 0 | Fax: +49 40 300672 - 11 | E-Mail: info[at]delta.de