Um Ihnen die Funktionen unseres Online-Shops uneingeschränkt anbieten zu können setzen wir Cookies ein. Weitere Informationen

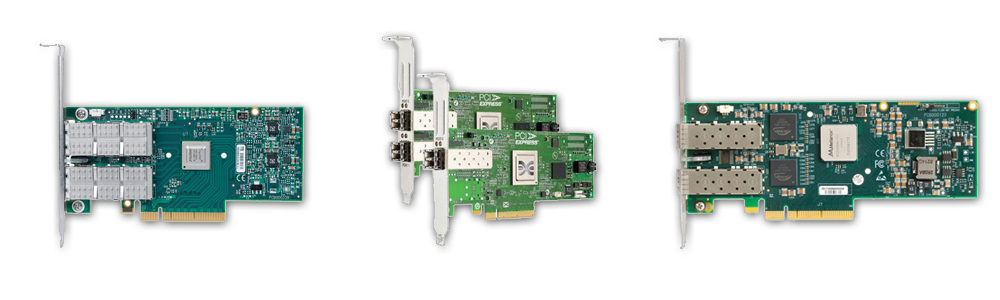

InfiniBand

InfiniBand wird nicht nur als MPI Cluster Interconnect eingesetzt, sondern findet zunehmend Verwendung im Bereich GPU Computing (GPU direct) und im High Performance Storage Umfeld. Mit IP over IB können z.B. mit minimalem Konfigurationsaufwand Daten extrem schnell im Netzwerk bereit gestellt werden. Bei höheren Anforderungen an die I/O-Rate empfehlen wir die parallelen Dateisysteme Lustre und BeeGFS, für die wir ebenfalls Support leisten. Mit der Einführung von PCIe 4.0 kann jetzt pro Rechner-Slot eine Bandbreite von 32 Gigabyte/s bereit gestellt werden, so dass die ConnectX-6 InfiniBand Karten, die derzeit z.B. in der NVIDIA DGX A100 verbaut sind, problemlos mit 200 Gigabit/s übertragen können.