Um Ihnen die Funktionen unseres Online-Shops uneingeschränkt anbieten zu können setzen wir Cookies ein. Weitere Informationen

Deep Learning Test Center

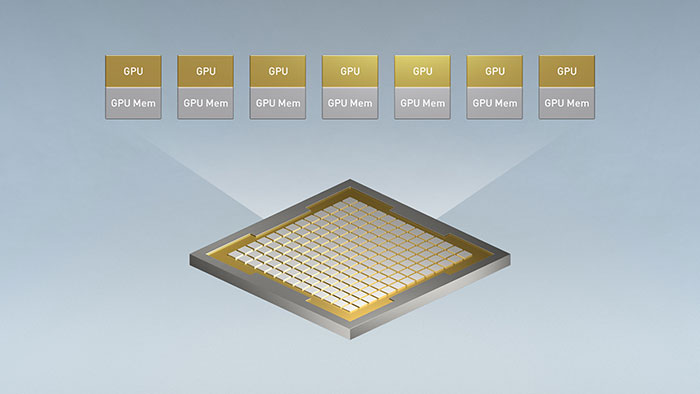

Die NVIDIA DGX B200 ist eine einheitliche KI-Plattform. Ausgestattet mit acht NVIDIA B200 Tensor Core-GPUs, die über NVIDIA NVLink der fünften Generation miteinander verbunden sind, bietet die DGX B200 eine bahnbrechende Leistung. Die NVIDIA Blackwell Architektur verleiht der DGX B200 nie dagewesene Leistung im Deep Learning Training und Inferencing. Zwei x86 CPUs, 30TB NVMe Speicher und 12x 200/400G Ethernet/InfiniBand Anschlüsse runden die DGX B200 ab. Im Rahmen der Elite Partnerschaft mit NVIDIA bietet DELTA für einen begrenzten Zeitraum Tests auf der DGX B200 via Remotezugang an. Wenn Sie an einem Test Interesse haben und entsprechende Projekte planen, können wir Sie für einen Test einplanen. Bitte füllen Sie das Anfrageformular für einen kostenlosen DGX B200 Benchmark aus oder schicken Sie uns eine E-Mail. Zwecks Speicherung und Verarbeitung ihrer Testdaten stehen unterschiedliche Storage Lösungen bereit, die ihren Wünschen entsprechend in die Testumgebung via NDR InfiniBand eingebunden werden können. Natürlich nehmen wir auch gerne eine individuelle Softwarekonfiguration vor. Falls die DGX B200 nicht in Ihr Budget passen sollte, können wir Ihnen nach Rücksprache auch andere Systeme aus unserem Portfolio für einen Remote Zugang zur Verfügung stellen. Bitte schicken Sie uns eine E-Mail mit ihren Projektdaten. Wir melden uns dann bei Ihnen, ob wir ein entsprechendes System für Testzwecke bereitstellen können. |

Schnellere Lösung größerer, komplexerer Datenwissenschaftsprobleme | Bereitstellung der Infrastruktur und operatives Skalieren der KI | Verkürzung der Zeit für Erkenntnisse und Beschleunigung der Kapitalrendite der KI | ||||

|  |  | ||||

Gerne besprechen wir alle weiteren Konfiguration im persönlichen Gespräch. Haben Sie Fragen zu unserem Test Center?

| ||||||

-

NVIDIA DGX H200 1128GB

NVIDIA DGX H200 1128GBAb 279.758,58 €

Die NVIDIA DGX H200 ist das erste System, das mit bahnbrechenden, durch NVIDIA Hopper™ angetriebenen H200-Grafikprozessoren bestückt ist und über NVIDIA NVLink™ 4.0 vernetzt ist.

- 32 petaFLOPS FP8

- ~10.2 kW max (6x redundant power supplies)

- 2x Intel® Xeon® Platinum 8480C CPUs

- Up to 2TB System + 1128GB GPU Memory

- NVMe Storage : 2x 1.9TB + 8x 3.84TB

- Up to 200Gb/s InfiniBand/Ethernet

- 8x NVIDIA SXM H200 141GB GPUs (max. 700 Watt TDP)

- NEU

NVIDIA DGX B200 1440GB

NVIDIA DGX B200 1440GBAb 301.920,77 €

Die NVIDIA DGX B200 ist eine einheitliche KI-Plattform. Ausgestattet mit acht NVIDIA B200 Tensor Core-GPUs, die über NVIDIA NVLink der fünften Generation miteinander verbunden sind, bietet die DGX B200 eine bahnbrechende Leistung.

- 72 petaFLOPS training + 144 petaFLOPS inference

- ~14.3 kW max (6x redundant power supplies)

- 2x Intel® Xeon® Platinum 8570 CPUs

- 2TB, max. 4TB System + 1440GB GPU Memory

- NVMe Storage : 2x 1.9TB + 8x 3.84TB

- Up to 400Gb/s InfiniBand/Ethernet

- 8x NVIDIA SXM B200 180GB GPUs (max. 1000 Watt TDP)

- NEU

NVIDIA DGX B300 2304GB

NVIDIA DGX B300 2304GBAb 354.834,42 €

Die NVIDIA DGX B300 ist eine einheitliche KI-Plattform. Ausgestattet mit acht NVIDIA B300 Tensor Core-GPUs, die über NVIDIA NVLink der fünften Generation miteinander verbunden sind, bietet die DGX B300 eine bahnbrechende Leistung.

- 72 petaFLOPS training + 144 petaFLOPS inference

- ~15kW max (12x redundant power supplies)

- 2x Intel® Xeon® Platinum 6776P CPUs

- 2TB, max. 4TB System + 2304GB GPU Memory

- NVMe Storage : 2x 1.9TB + 8x 3.84TB

- Up to 800Gb/s InfiniBand/Ethernet

- 8x NVIDIA SXM B300 288GB GPUs (max. 1400 Watt TDP)

- NEU

NVIDIA DGX Spark4.084,71 €

NVIDIA DGX Spark4.084,71 €NVIDIA DGX™ Spark wird vom NVIDIA GB10 Grace Blackwell Superchip unterstützt und bietet eine PetaFLOP KI-Leistung in einem energieeffizienten, kompakten Formfaktor.

- NVIDIA GB10 Grace Blackwell

- 20 core Arm, 10 Cortex-X925

+ 10 Cortex-A725 Arm CPU - 128 GB LPDDR5x, unified system memory

- 4 TB NVME

- ConnectX-7 Smart NIC

- NVIDIA DGX™ OS